一、说明

可以将同一个局域网中的手机、平板、电脑组合起来实现AI推理集群,例如:使用雷电接口将几台Mac mini连接起来。

GitHub:https://github.com/exo-explore/exo

二、安装

根据github的文章安装即可

注意:

- 使用python虚拟环境安装

- mac需要开启mlx(苹果公司推出的推理框架)

三、使用

1. 运行

设置国内的HF-Mirror镜像站点

# 查看帮助

HF_ENDPOINT=https://hf-mirror.com exo -h

# 直接启动

HF_ENDPOINT=https://hf-mirror.com exo

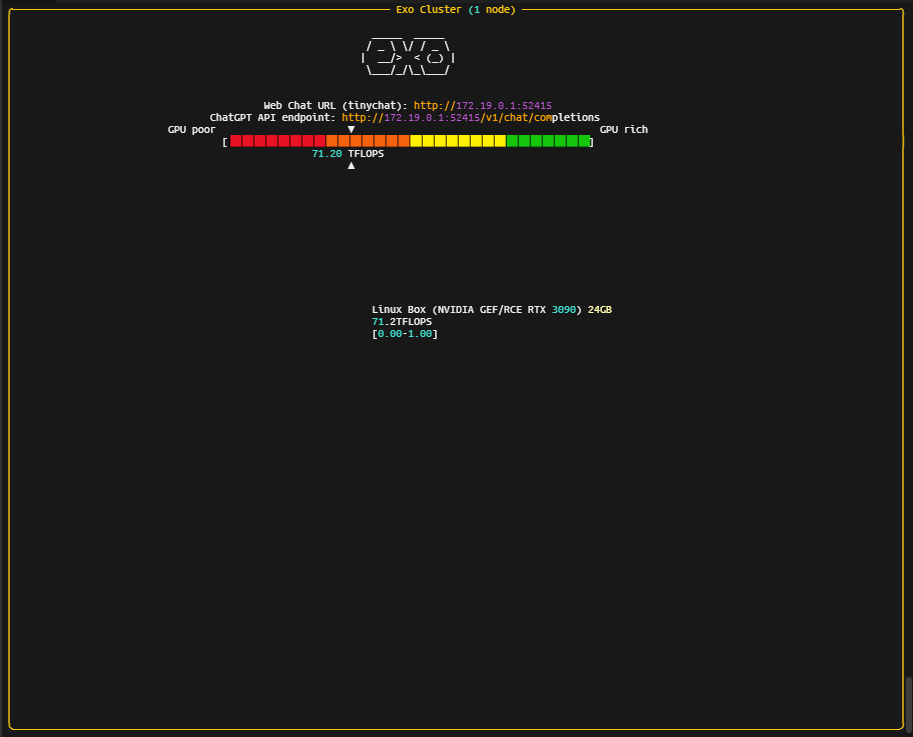

启动成功后

2. 访问

tinychat:http://xxx.xxx.xxx.xxx:52415/

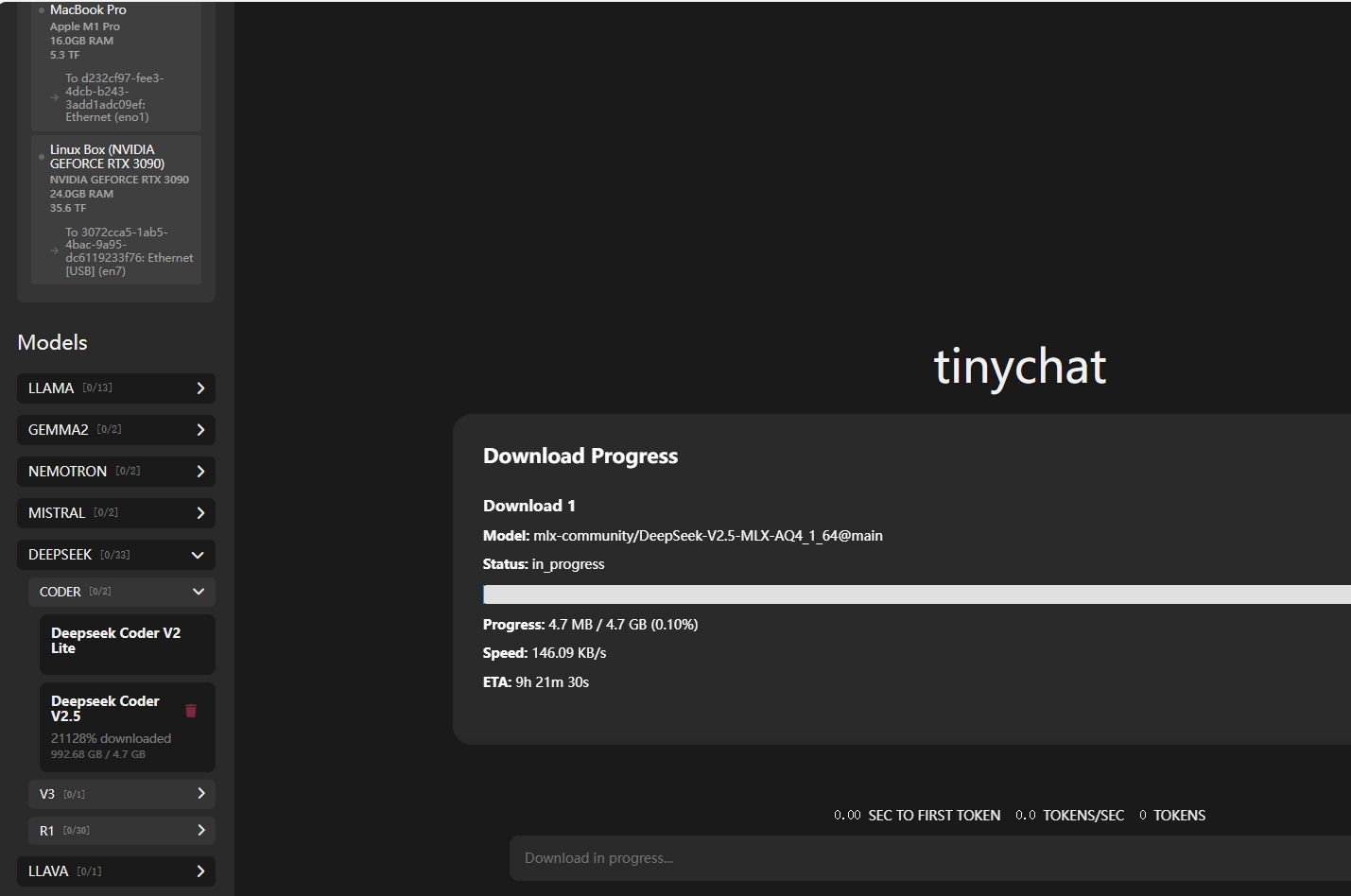

3. 下载模型

注意: 先将集群跑起来,再进行下载,所有节点会参与下载,不同架构下载不同的模型文件

-

在tinychat中下载

-

使用huggingface-cli下载指定仓库的模型(文档较少,不推荐)

# mac环境模型下载

# mac仅支持mlx推理框架

# https://hf-mirror.com/mlx-community

huggingface-cli download --resume-download mlx-community/DeepSeek-R1-Distill-Qwen-32B-4bit --local-dir DeepSeek-R1-Distill-Qwen-32B-4bit

# ubuntu环境模型下载

# ubuntu环境仅支持tinygrad推理框架

# https://hf-mirror.com/NousResearch

huggingface-cli download --resume-download NousResearch/Meta-Llama-3.1-70B-Instruct --local-dir Meta-Llama-3.1-70B-Instruct

手动下载完成迁移到目录:~/.cache/exo/downloads

注意:

目前ubuntu和mac环境下都能下载Llama模型,但仅有mac环境下可以下载DeepSeek-R1模型

参考文章

exo - 利用家用设备打造低成本的 AI 集群:https://zhuanlan.zhihu.com/p/7693213678